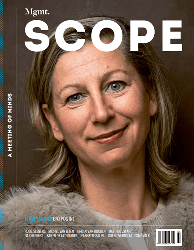

Ethische kwesties rondom robotisering en algoritmes, dat is het vakgebied van Aimee van Wynsberghe

'Bestuurders, analyseer uw algoritmes'

Aimee van Wynsberghe in gesprek met Frank Geelen

19-06-2019 | Interviewer: Frank Geelen | Auteur: Paul Groothengel | Beeld: Emile Vrolijk

Robotonderzoeker en ethicus Aimee van Wynsberghe is Canadese en heeft een Nederlandse vader, die na de Tweede Wereldoorlog naar Canada ging. Decennia later kwam Van Wynsberghe er na een master in Leuven achter dat haar ideale promotieplek in Nederland ligt, bij de Universiteit Twente. Daar promoveerde ze zeven jaar geleden op de ethische beoordeling van zorgrobots en ontwierp hier een praktisch kader voor. Later volgde haar boek Healthcare Robots: Ethics, Design, and Implementation.

‘Ik ben na mijn promotie in Nederland gebleven, ik houd van dit land,’ zegt Van Wynsberghe, die inmiddels assistent- hoogleraar ethiek en technologie is aan de TU Delft. Daarnaast houdt ze zich ook binnen de Foundation for Responsible Robotics, die ze mede oprichtte, bezig met ethische kwesties rond robotisering. Zoals: willen we als mensheid een robot zelfstandig een operatie uit laten voeren? Wie is er verantwoordelijk als er iets misgaat? En hoe ziet een toekomst eruit waarin mensen seks hebben met robots? The Foundation for Responsible Robotics en Deloitte werken samen aan een gecertificeerd keurmerk voor artificial intelligence en robotics. Dit keurmerk moet zorgen voor een industriestandaard om de verantwoordelijkheid voor het ontwerpen, ontwikkelen en produceren van robots nauwkeurig te kunnen beoordelen. Het doel is belangrijke kenmerken van producten uit te lichten die bijdragen aan een betere wereld, zoals milieubescherming, duurzaamheid, integriteit, ethisch ontwerp, veiligheid en beveiliging met aandacht voor de maatschappelijke impact en mensenrechten. Dit keurmerk moet consumenten helpen om weloverwogen beslissingen te nemen.

Van Wynsberghe zit ook, samen met 50 andere experts in de High Level Group on Artificial Intelligence die de Europese Commissie vorig jaar in het leven riep, met als doel te helpen bij de beeldvorming en regelvorming rondom kunstmatige intelligentie. Deze denktank heeft als opdracht na te denken over het formuleren van ethische richtlijnen.

Bedrijven kijken met argusogen naar dit soort ontwikkelingen, want met de toename van kunstmatige intelligentie nemen voor hen niet alleen de mogelijkheden toe, maar ook de risico’s – denk bijvoorbeeld aan de schade die zelfrijdende auto’s aan mensen kunnen toebrengen. In hoeverre kunnen we in de toekomst machines op een ethisch verantwoorde manier ontwerpen, ontwikkelen, inzetten en reguleren? Dat blijft mensenwerk. Dat leidt naar de filosofische kernvraag: wat is nou wel en wat niet ethisch verantwoord? En wie mag of moet dat bepalen? We spreken ethicus Van Wynsberghe in de Nieuwe Kerk in Amsterdam, voorafgaand aan een Deloitte-evenement voor ceo’s en cfo’s, waar zij een van de sprekers was.

Hoever zijn we met het verbinden van ethiek met kunstmatige intelligentie (KI)?

‘We staan nog maar aan het begin van de ontwikkeling van kunstmatige intelligentie, zeker waar het gaat om de relatie met ethiek en effecten op lange termijn. Wat dat betreft kun je een parallel trekken met het denken over kernenergie: in het begin dacht men alleen aan de voordelen daarvan op de korte termijn, pas veel later kwam daar de ethische afweging bij inzake het probleem met het nucleaire afval, dat een duidelijk langetermijneffect genoemd kan worden.

Ethiek kan ons veel brengen, het verlangt van ons dat we nadenken over onbedoelde gevolgen van robotica en kunstmatige intelligentie. Zo heeft het succes van Facebook ervoor gezorgd dat het concept vriendschap is veranderd: een typisch langetermijneffect dat door niemand was voorzien. Zo kan ook ons concept van de term verantwoordelijkheid in de loop der tijd gaan schuiven. Omdat we ons met kunstmatige intelligentie ofwel KI nog in zo’n vroege fase bevinden, betekent dat per definitie dat we nog veel moeten leren, ook wat betreft de relatie tussen ethiek en KI.’

Is het, aangezien er nog zoveel onduidelijk is over de ethische kant rond kunstmatige intelligentie, wellicht ethischer om het gebruik van moderne technologie en robots waar mogelijk te vermijden?

‘Het zou een groot statement zijn om te stellen dat we de morele verplichting hebben om de nieuwste KI wél te gebruiken. In de medische wereld lijkt het voor de hand te liggen dat die verplichting er wel is, maar dat gaat alleen op als je zeker weet dat je met robots of algoritmes daadwerkelijk de zorg voor patiënten kunt verbeteren. Een technologie als het convolutionele neurale netwerk kan een verdacht plekje op iemands huid aanmerkelijk beter diagnosticeren dan een dermatoloog, en zo met een veel grotere slagingskans mogelijke huidkanker opsporen. Maar recente studies laten zien dat, zodra je een paar datapunten in een dataset van zo’n netwerk verandert, deze technologie snel aan accuratesse verliest. Dus je moet deze kunstmatige intelligentie hoe dan ook goed blijven testen.

Pas als we echt zeker zijn van de voorspellende waarde van een technologie – denk aan het kunnen voorspellen van een aardbeving – bestaat er in mijn ogen de morele verplichting om die technologie ook echt te gebruiken.’

Is het de morele plicht van de overheid om burgers te beschermen tegen schending van privacy en kwalijke uitwassen van robotica, of kun je dat beter aan de markt overlaten?

‘Ik denk dat dat een plicht is voor allebei – en dan gaat het vooral om het vinden van een goede balans daartussen. Natuurlijk lijkt dit op het eerste gezicht als eerste een taak van de overheid. Maar kun je een overheid altijd vertrouwen, denkend aan China, de Filippijnen en ook de Verenigde Staten? Dat is zeer de vraag. Daarom ben ik ook vol overtuiging lid geworden van de High Level Group on Artificial Intelligence van de Europese Commissie, die ethische richtlijnen ten aanzien van het gebruik van kunstmatige intelligentie wil opstellen. In de Verenigde Staten zet de regering nu ook in op trustworthy artificial intelligence en zelfs China toont steeds meer interesse in ethische regelgeving rond KI.

Los van de rol van overheden moeten bedrijven en zeker ook consumenten en consumentenorganisaties zich eveneens bezighouden met ethische vraagstukken rond vormen van kunstmatige intelligentie. Hun groeiende invloed valt niet te onderschatten – zie de toenemende vraag naar slaafvrije chocola, fairtrade coffee en recyclebaar plastic, of de draai die een concern als Unilever maakt. Vaak is het een kwestie van lange adem voor een industrie verandert. Toen de veiligheidsriem in de auto verplicht werd gesteld, gilde de autoindustrie moord en brand. Dat soort regelgeving zou de innovatie in de sector tegengaan. Dat bleek onzin te zijn. Nu hoor je dat ethische richtlijnen de innovatie rondom kunstmatige intelligentie zouden vertragen. Daar geloof ik niets van. Het gaat niet om vertragen, maar om het zoeken naar de beste ontwerpkeuzes, op een ethisch verantwoorde wijze. Als we op de juiste manier met ethische richtlijnen omgaan, zal dat innovatieprocessen alleen maar ondersteunen.’

Welke ethische vragen zouden organisatiebestuurders, die vaak wordt verweten meer bezig te zijn met de komende kwartaalwinst dan met ethiek, zich vandaag de dag moeten stellen?

‘Begin maar met een analyse waaruit blijkt of de data en de algoritmes die je gebruikt, ethisch gezien door de beugel kunnen. Algoritmes zijn bovengemiddeld vaak vooringenomen. Als onjuiste gegevens zijn gebruikt, krijg je slechte resultaten. Garbage in, garbage out. Daarom noemt de wiskundige Cathy O’Neil algoritmes ook wel weapons of math destruction. Bekend is het voorbeeld van Amazon: die webgigant gebruikte jarenlang een recruitment tool die cv’s van sollicitanten analyseerde, en daar dan de beste kandidaten uit filterde. De algoritmes hadden zichzelf een zeer sterke voorkeur voor mannen aangeleerd. Tja – en dat voor een bedrijf waarin zoveel briljante mensen rondlopen.

Een van de oplossingen om herhaling van iets dergelijks te voorkomen, is dat je goed let op een diverse samenstelling van een ontwerpteam: dat daar niet alleen maar jonge, witte mannen in zitten, zoals je in Silicon Valley nou eenmaal vaak ziet. Hoe dan ook, er komt wereldwijd een enorme beweging op gang die ethische vraagstukken naar voren schuift, wat vroeg of laat kan leiden tot nieuwe regelgeving. Het onderwerp mag dus op geen enkele managementagenda ontbreken. Je kunt wegkijken en doen of er niets gebeurt, maar dat lijkt mij nogal risicovol. Je kunt als bestuurder beter voorop gaan in de verandering. Een ethisch verantwoorde attitude ten aanzien van de inzet van kunstmatige intelligentie, kan voor een bedrijf zelfs leiden tot een unique selling point.’

Andersom kan het ook desastreus uitpakken, als je het níet goed aanpakt?

‘Zeker. Dat zagen we laatst nog bij techbedrijf Google, dat in april het eigen external ethics committee na een week alweer moest stopzetten: ze hadden daarin ook Kay Coles James opgenomen, de controversiële president van de Heritage Foundation. Zij is een uitgesproken tegenstander van meer rechten voor de lhbti-gemeenschap en verzet zich tegen maatregelen om klimaatverandering in te perken. Binnen no time ondertekenden duizenden Google-medewerkers een petitie tegen haar komst, omdat ze haar standpunten ethisch onverantwoord vinden. Het uiteindelijke effect was voor Google dus niet positief maar negatief.’

U staat mede aan de wieg van de Foundation for Responsible Robotics. Wat is het doel van de foundation?

‘We willen een platform zijn waar bedrijven en wetenschappers elkaar kunnen ontmoeten en kennis, standpunten en ervaringen met elkaar kunnen delen. De laatste jaren zien we binnen de academische wereld veel fascinerende ontwikkelingen, bedrijven moeten daar absoluut kennis van nemen. Daarnaast willen we invloed kunnen uitoefenen en onze stem laten horen richting de politieke arena. We willen het publieke bewustzijn rond ethiek, robotica en kunstmatige intelligentie vergroten, onder meer door het schrijven van consultatiedocumenten.’

Als belastingadviseurs lopen wij ook tegen ethische grenzen aan. De aloude mantra pay as little as you can geldt niet meer, zeker niet als je als bedrijf actief bent in b-to-c markten. Wat te doen?

‘Dat hangt af van de omvang van je onderneming, in welke markten je actief bent…’

Dat is ethisch gezien toch geen goed argument?

‘Inderdaad, daar heb je een punt. Ik denk dat er voor iedere organisatie die bezig is met vormen van kunstmatige intelligentie, ruimte is om actief te zijn of te worden op ethisch gebied. Praktisch? Zoals bedrijven sinds de invoering van de Algemene Verordening Gegevensbescherming vorig jaar verplicht zijn een data protection officer aan te stellen, zouden ze een ethicus moeten aanstellen die in iedere schakel van de waardenketen, zeker waar het gaat om kunstmatige intelligentie, meekijkt of het bedrijf zich houdt aan ethische normen en waarden. Zoals jullie bij Deloitte een chief ethics officer hebben.

Ik geloof niet dat we van machines of algoritmes mogen verwachten dat ze zichzelf leren om zich ethisch te gedragen, daar heb je toch echt mensen voor nodig, denk aan ontwerpers, engineers, marketeers maar ook regelgevers. Een robot kent geen moraal, die is alleen goed in supersnelle berekeningen. En vervolgens heb je dan uiteraard de meer filosofische vraag hoe je die ethiek dan precies invult, wat je eronder verstaat. Wie moet je, nadat een zelfrijdende auto pardoes iemand heeft doodgereden, daarvoor verantwoordelijk houden? De ontwerper van de auto? Zijn bedrijf? De persoon die in de auto zit? Of had degene die is aangereden, maar beter moeten opletten? De antwoorden daarop weet ik ook niet. Dat vergt voor dekomende jaren nog veel discussie.’

Gepubliceerd in Management Scope 06 2019.